近日,我校數(shù)學與信息學院、軟件學院2021級本科生尹商鑒撰寫的論文“Uni-MIS: United Multiple Intent Spoken Language Understanding via Multi-view Intent-slot Interaction”被人工智能領域頂級學術會議AAAI-24 (The 38th AAAI Conference on Artificial Intelligence)錄用。指導老師為黃沛杰和徐禹洪,尹商鑒為論文第一作者,黃沛杰為通訊作者。

AAAI是人工智能領域的頂級國際會議(中國計算機學會CCF-A類推薦國際會議),聚集了全球人工智能領域的專業(yè)人士,共同探討人工智能發(fā)展前沿。AAAI-24將于2024年2月20日-27日在加拿大溫哥華召開。

口語語言理解(Spoken language understanding, SLU)在以任務為導向的人機對話系統(tǒng)中發(fā)揮著至關重要的作用,其主要目的是構建一個語義框架,以封裝用戶的請求。在現(xiàn)實生活場景中,用戶經(jīng)常會在單個話語中表達多個意圖,因此多意圖SLU成為了研究熱點。然而,現(xiàn)有的研究方法普遍面臨細粒度的意圖-槽交互缺失問題,在意圖識別和槽信息填充的過程中,缺乏對不同粒度意圖信息的綜合考慮,導致模型在處理復雜語言現(xiàn)象時性能受限。

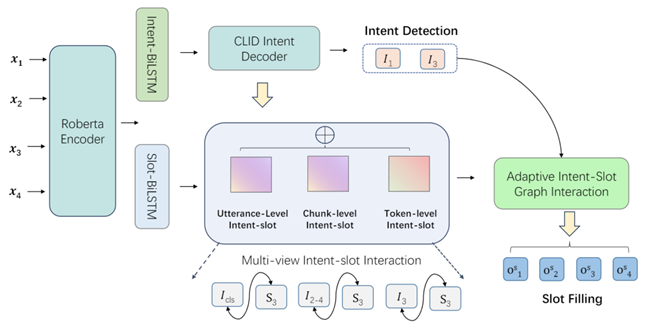

模型框架圖

為了解決這一問題,論文受到多視圖理論的啟發(fā),從意圖和槽的不同視角出發(fā)嘗試找到解決方法。具體上,論文設計了一個自適應的多視圖意圖-槽信息融合框架,能夠在不同意圖層級(如語篇級、詞元級和塊級)之間實現(xiàn)信息融合,從而更全面地捕捉話語意圖的多樣性和復雜性,并有效指導槽信息填充任務。

通過在兩個廣泛使用的公開數(shù)據(jù)集上的對比實驗表明,尹商鑒等人的方法有效地提高了多意圖SLU的性能。

近年來,數(shù)學與信息學院、軟件學院高度重視學生的創(chuàng)新能力和科研素養(yǎng)的培養(yǎng),支持學生自主開展創(chuàng)新科研活動及參加各級各類科創(chuàng)競賽,鼓勵學生選擇科研導師,進入科研實驗室,完成科研創(chuàng)新能力的進階,在本科人才培養(yǎng)方面取得了豐碩的成果。

文圖/數(shù)學與信息學院、軟件學院